Веб-скреппинг, также известный как сбор информации с веб-сайтов или извлечение данных с веб-сайтов, представляет собой процесс извлечения и систематизации данных с веб-сайта. Это ценный метод сбора информации из различных источников, автоматизации задач и проведения исследований. С увеличением объема данных, доступных в Интернете, веб-скрепинг стал необходимым навыком для многих специалистов, включая маркетологов, исследователей и аналитиков данных.

Существует несколько способов поиска информации на сайте: от ручного извлечения до использования специализированного программного обеспечения или написания собственного кода. Ручное извлечение предполагает копирование и вставку данных с сайта в электронную таблицу или текстовый документ, что требует много времени и чревато ошибками. С другой стороны, использование программного обеспечения или создание кода позволяет автоматизировать процесс и извлекать данные с нескольких страниц или сайтов.

При размещении веб-страниц важно учитывать юридические и этические последствия. Некоторые сайты запрещают скраппинг или имеют специальные правила, поэтому обязательно прочитайте и поймите условия использования сайта. Также следует уважать ресурсы сервера сайта и не перегружать его большим количеством запросов. При использовании соскобленных данных всегда рекомендуется идентифицировать себя и указывать авторство.

Что такое веб-скрепинг?

Веб-скрепинг - это техника извлечения данных с веб-сайта. Она заключается в автоматической отправке HTTP-запросов на сайт и анализе HTML-ответов для извлечения необходимой информации. Обычно этот процесс осуществляется программно с помощью специального программного обеспечения или библиотек.

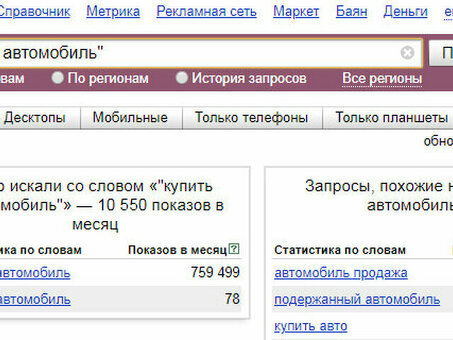

Веб-скрепинг обычно используется для различных целей, включая сбор данных для маркетинговых исследований, отслеживание цен на сайтах электронной коммерции и создание наборов данных для анализа. Он позволяет пользователям получить доступ к данным, которые не доступны в структурированном виде, что экономит время и силы по сравнению с ручным сбором данных.

При скраппинге важно соблюдать условия использования сайта и не перегружать сервер избыточными запросами. Для обеспечения успеха процесса скраппинга важно также устранить потенциальные препятствия, такие как CAPTCHA и меры защиты от скраппинга.

Веб-скреппинг может выполняться с использованием различных методик, например, поиск определенных HTML-элементов с помощью регулярных выражений, XPath и CSS-опций. После определения необходимых элементов собранные данные могут быть извлечены и сохранены в структурированных форматах, таких как CSV-файлы или базы данных.

В целом, веб-скрепинг является мощным инструментом для извлечения данных с веб-сайтов. Он позволяет получить доступ к огромному количеству информации, которую можно использовать в самых разных целях - от проведения маркетинговых исследований до создания инновационных приложений на основе новейших данных.

Преимущества организационного скраппинга

Веб-скрепинг - это мощный инструмент, который дает множество преимуществ как частным лицам, так и компаниям. Среди основных преимуществ использования организационного скраппинга можно назвать следующие

- Извлечение данных: с помощью веб-скрепинга можно извлекать из веб-сайта необходимые и ценные данные, такие как сведения о продукте, информация о ценах и отзывы клиентов. Эти данные могут быть использованы для различных целей, таких как маркетинговые исследования, анализ конкурентов и бизнес-аналитика.

- Автоматизация: веб-скрепинг может использоваться для автоматизации повторяющихся и трудоемких задач, позволяя экономить время и силы. Вместо того чтобы вручную копировать и вставлять данные с нескольких веб-сайтов, инструменты веб-скрепинга позволяют автоматически собирать и консолидировать необходимую информацию.

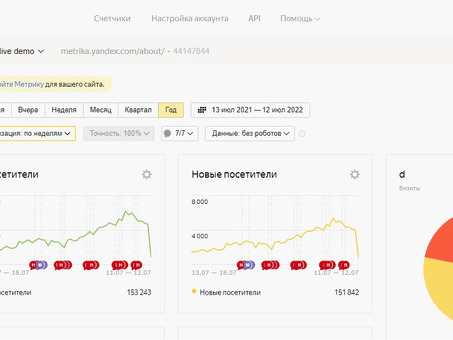

- Обновления в реальном времени: веб-скрепинг позволяет пользователям всегда быть в курсе самой свежей информации, доступной на сайте. Регулярный скраппинг данных позволяет компаниям отслеживать изменения цен, наличие товара на складе, обновление новостей и другие важные данные, что дает возможность принимать обоснованные решения в режиме реального времени.

- Анализ конкурентов: веб-скрепинг позволяет получить ценную информацию о стратегии и деятельности конкурентов. Собирая данные с сайтов конкурентов, компании могут анализировать ценообразование, товарные предложения, маркетинговые кампании и другие ключевые факторы для получения конкурентных преимуществ.

- Поиск потенциальных клиентов: с помощью веб-скрепинга с веб-сайтов можно извлекать контактную информацию, такую как электронные адреса и номера телефонов. Эти данные могут использоваться для генерации лидов, проведения маркетинговых кампаний по электронной почте и изучения перспектив продаж, помогая компаниям выявлять и находить потенциальных клиентов.

Таким образом, веб-скрепинг дает множество преимуществ: от извлечения данных и автоматизации до обновления информации в режиме реального времени и анализа конкурентов. Используя инструменты и технологии веб-скрепинга, компании могут получить ценные сведения, оптимизировать процессы и добиться успеха в современную цифровую эпоху. Принятие решений на основе данных.

Начало работы с веб-скреппингом

Веб-скрепинг - это процесс извлечения данных с веб-сайтов с помощью автоматизированного программного обеспечения, известного также как веб-скреперы. Этот метод широко используется в различных отраслях, включая электронную коммерцию, исследования и маркетинг, поскольку позволяет быстро и эффективно собирать и анализировать большие объемы данных.

Зачем нужен веб-скрепинг?

Веб-скрепинг - это мощный инструмент, позволяющий компаниям и частным лицам автоматизировать процесс извлечения данных и сэкономить время и силы: с помощью веб-скрепинга можно извлекать такие данные, как цены на товары, отзывы покупателей и данные о запасах, сразу с нескольких веб-сайтов.

Инструменты для организационного скраппинга

Существует множество программных инструментов и библиотек, которые можно использовать для веб-скрепинга на различных языках программирования. Среди популярных вариантов - Beautiful Soup (Python), Scrapy (Python), Selenium (Python и Java) и Octoparse (web-based). Эти инструменты предлагают широкий спектр возможностей и функций, позволяющих упростить и повысить эффективность организационного скраппинга.

Понимание структуры HTML

Поскольку веб-страницы строятся с использованием HTML-кода, прежде чем приступать к соскабливанию веб-страниц, необходимо понять базовую структуру HTML. Понимание тегов, атрибутов и элементов HTML поможет определить данные для извлечения и создать эффективные сценарии соскабливания. Это поможет вам определить данные, которые необходимо извлечь, и создать эффективные сценарии веб-скрапинга.

Правовые и этические вопросы

Веб-скрепинг - это мощный инструмент, но важно знать о юридических и этических аспектах. На некоторых сайтах существует политика, запрещающая веб-скреппинг, поэтому важно соблюдать эти правила и при необходимости получать разрешение. Кроме того, важно учитывать конфиденциальность данных и ответственно подходить к использованию извлеченных данных.

В целом, веб-скреппинг является ценным методом извлечения данных с веб-сайтов. Понимание основ, выбор правильных инструментов и соблюдение правовых и этических норм позволят вам использовать возможности веб-скрепинга для получения нужных данных.

Понимание структуры HTML

Когда речь идет о веб-скреппинге, важно понимать структуру HTML-кода сайта - HTML означает Hypertext Markup Language (язык разметки гипертекста) и является основой всех веб-страниц. Это язык разметки, определяющий структуру и представление контента в Интернете.

HTML-документ состоит из вложенных элементов, образующих иерархическую структуру. Каждый элемент представлен определенной меткой, которая определяет его назначение и внешний вид. Например, для определения абзацев используются метки & amp; lt; p& amp; gt; tag & amp; lt; ul& amp; gt;. Он используется для создания неупорядоченных списков.

Помимо тегов, в HTML используются атрибуты для предоставления дополнительной информации об элементах. Атрибуты могут использоваться для определения стиля, поведения или других характеристик элемента. К числу распространенных атрибутов относятся class, id и href.

Структура HTML очень важна для веб-скреппинга, поскольку позволяет находить и извлекать конкретные данные с сайта. Понимание иерархии элементов позволяет определить соответствующие теги и атрибуты, на которые следует ориентироваться. Например, если необходимо просканировать список названий товаров с сайта электронной коммерции, можно найти HTML-теги (например, & amp; lt; h3& amp; gt;), связанные с этими названиями. или & amp; lt; span& amp; gt;.

Важно также отметить, что структура HTML может отличаться на разных сайтах. Каждый сайт может иметь свою уникальную разметку и структуру элементов. Поэтому, чтобы понять их структуру, необходимо изучить HTML-код конкретного сайта, который вы хотите просканировать.

Таким образом, понимание структуры HTML очень важно для успешного веб-скреппинга. Это позволяет использовать иерархическую природу HTML-элементов для навигации по сайту и извлечения из него данных. Знакомство с различными тегами и функциями позволяет эффективно находить нужные данные и автоматизировать процесс извлечения.

Выбор языка программирования для веб-скрепинга

Когда речь идет о веб-скреппинге, важно выбрать правильный язык программирования. От того, какой язык программирования вы выберете, будет зависеть простота и эффективность процесса веб-скрепинга.

Популярным языком программирования для веб-скрепинга является Python, который известен своей простотой и легкостью в использовании, что делает его отличным выбором для начинающих. Кроме того, Python имеет большое и активное сообщество, что позволяет легко найти необходимую помощь и ресурсы.

Другим языком программирования, широко используемым для скраппинга сайтов, является JavaScript, который известен своей способностью взаимодействовать с Интернетом, что делает его мощным инструментом для скраппинга сайтов. Существуют различные библиотеки, такие как Puppeteer и Cheerio, которые можно использовать для организационного скраппинга; JavaScript также широко поддерживается веб-браузерами, что делает его гибким выбором для динамического веб-скраппинга.

Среди других языков программирования, которые могут быть использованы для веб-скрепинга, можно назвать Ruby, PHP и Java. Эти языки имеют свой собственный набор библиотек и фреймов, которые можно использовать для организационного скраппинга, но, возможно, не так широко поддерживаются и не так велики, как Python или JavaScript.

Наконец, выбор языка программирования зависит от ваших личных предпочтений, сложности сайта, который вы хотите скреативить, и специфических возможностей, которые вам необходимы. Перед принятием решения важно учесть такие факторы, как синтаксис, наличие библиотек, поддержка сообщества и знакомство с языком.

Установка необходимых библиотек

Для запуска сайта необходимо установить необходимые библиотеки. Эти библиотеки предоставляют инструменты и функциональность, необходимые для экспорта данных с сайта.

Одной из наиболее популярных библиотек для скраппинга веб-сайтов является BeautifulSoup - библиотека Python, способная анализировать HTML- и XML-документы. Она предоставляет простой и интуитивно понятный способ навигации, поиска и обработки проанализированных данных. Для установки BeautifulSoup можно воспользоваться пакетом PIP, выполнив в терминале следующую команду.

PIP install beautifulsoup4

Еще одной библиотекой, полезной для скраппинга сайтов, является Request. Request - это библиотека Python, позволяющая отправлять HTTP-запросы и обрабатывать ответные данные, упрощая процесс выполнения HTTP-запроса и обеспечивая более высокий уровень интерфейса по сравнению со встроенной секцией urlib. Для установки Request можно воспользоваться менеджером пакетов PIP, выполнив следующую последовательность действий

PIP Install Request.

Помимо BeautifulSoup и запроса, может потребоваться установка других библиотек в зависимости от конкретных требований к веб-скраппингу. Например, если необходимо взаимодействовать с элементами сайта на основе JavaScript, может потребоваться установка таких библиотек, как Selenium; для установки Selenium можно использовать PIP.

PIP установить Selenium

После установки необходимых библиотек можно приступать к размещению информации на сайте - введите библиотеки в Python-скрипт и не забудьте обратиться к дальнейшим инструкциям по использованию функционала.

Организационные техники скраппинга

Под методами веб-скрепинга понимаются различные методы и инструменты, используемые для извлечения данных с веб-сайта. Эти методы включают в себя восстановление данных с веб-сайтов и автоматизацию организационных процессов, позволяя пользователям получать необходимую информацию в структурированном виде для анализа или других целей.

1. HTML-анализ: одной из наиболее распространенных технологий веб-скреппинга является HTML-решение, которое заключается в анализе глубинной структуры HTML-кода сайта. Эта техника позволяет экспортировать конкретные элементы, такие как заголовки, абзацы и таблицы, путем определения соответствующих HTML-меток и их функции.

2. Вопросы XPath: XPath - это язык запросов, используемый для навигации в XML-документах, включая HTML; XPath позволяет веб-скреперам задавать определенные маршруты или шаблоны для идентификации и экспорта данных с веб-сайта. Эта техника особенно полезна в отношении сложных или HTML-структур. 3.

Регулярные выражения: регулярные выражения, или regular expressions, являются мощными инструментами для сопоставления и экспорта шаблонов; Regex позволяет веб-скрейперам задавать шаблоны для идентификации и экспорта определенных шаблонов данных с веб-сайта. Эта техника часто используется, когда экспортируемые данные имеют определенную форму или структуру. 4.

4. интеграция API: некоторые веб-сайты предоставляют интерфейс планирования приложений (API), который позволяет программистам получать доступ к данным и восстанавливать их в структурированном виде; интеграция API в организационный скраппинг позволяет разработчикам экспортировать данные без анализа HTML-кода или использования других средств. 4. прямой доступ к необходимым данным без анализа HTML-кода или использования других технологий экспорта

5. динамически-организационный скраппинг: динамически-организационный скраппинг подразумевает экспорт данных с сайта, который в основном основан на JavaScript или Ajax. Для скрапинга таких сайтов требуется, чтобы веб-скреперы имитировали взаимодействие с пользователем и выполняли JavaScript-код для извлечения и экспорта нужных данных.

6. Ограничение ритма и прокси: чтобы избежать обнаружения и предотвратить блокировку IP-адресов, веб-скраперы часто используют методы ограничения ритма для контроля скорости создания приложений на сайте. Кроме того, использование прокси позволяет скреперам подавать заявки через разные IP-адреса, что еще больше анонимизирует процесс скрепинга.

В целом, методы веб-скреппинга необходимы для эффективного извлечения данных с веб-сайта. В зависимости от сложности сайта и извлекаемых данных для достижения желаемых результатов могут использоваться различные подходы и инструменты.

Использование CSS-селекторов

Широко распространенным приемом при скраппинге сайта является использование CSS-селекторов, которые позволяют выделить определенные элементы на веб-странице и извлечь необходимую информацию.

Select by tag name: позволяет выделить элементы по имени тега, например, выделить все абзацы на странице. Это можно сделать с помощью следующих командpСелектор.

Выбор по имени класса: если элемент на веб-странице имеет определенное имя класса, можно воспользоваться селектором.. Имя класса.Используйте селекторы для выделения этих элементов. Например, можно выбрать все элементы с именем класса highlight.

Выбор по ID: если элемент имеет уникальный ID, можно использовать селектор .#id.Используйте селектор для конкретного выбора элемента. Это полезно при отборе веб-страниц, содержащих определенные элементы с уникальными идентификаторами.

Выбор по атрибутам: можно также выбирать элементы на основе атрибутов. Например,Target = "_ blank"Атрибут. Это можно сделать с помощью следующей команды[attribute = value].Селектор.

Вложенные селекторы: вы можете комбинировать и вкладывать CSS-селекторы, чтобы нацелить их на определенные элементы внутри других элементов. Например, можно выбрать все неупорядоченные списки внутри div с именем класса.Контейнер..

Выбор элементов-братьев: селектор CSS можно использовать и для выбора элементов-братьев, например, для выбора всех элементов списка, следующих сразу за элементом заголовка. Это можно сделать с помощью следующих команд+Селектор.

Выбор нескольких элементов: CSS Selector можно использовать для выбора и извлечения информации сразу из нескольких элементов, например, для выбора всех ячеек таблицы. Это можно сделать с помощью селектора,Селектор.

В целом, CSS-селекторы обеспечивают мощный и гибкий способ выделения определенных элементов на веб-странице в процессе веб-скреппинга. Различные типы селекторов могут быть использованы для извлечения необходимой информации и автоматизации процесса веб-скрапинга.

Скраппинг с помощью XPath

XPath - это метод, используемый в веб-скрейпинге для извлечения данных с веб-сайта с помощью выражений XPath. XPath - это язык, используемый для навигации и запроса XML-документов, а также для поиска элементов в HTML-документах. XPath позволяет разработчикам находить и извлекать определенные элементы данных из HTML-структуры сайта.

Одним из преимуществ XPath-скреппинга является гибкость поиска элементов: с помощью XPath можно задать широкий спектр критериев поиска, включая атрибуты элементов, текст элементов, расположение элементов и иерархию элементов. Это позволяет легко находить конкретные элементы на сайте, даже если их структура или форматирование изменились с течением времени.

При выполнении XPath-скреппинга разработчики часто указывают элементы, которые необходимо отскрести, с помощью XPath-селекторов - выражений, которые сопоставляют элементы на основе их атрибутов или текстового содержимого. Например, селектор XPath может быть направлен на всеpЭлементы с определенным именем класса или все.aElements with a specific text value.

После того как нужные элементы найдены, разработчики могут извлекать данные с помощью функций XPath, которые также могут использоваться для извлечения атрибутов элементов или текста элементов и выполнения вычислений над полученными данными. Например, функция XPath может быть использована для извлеченияhref.ссылку, текстовое содержание абзаца или сумму всех значений, указанных на веб-странице.

В заключение следует отметить, что XPath-скрепинг - это мощный метод веб-скрепинга, позволяющий разработчикам извлекать данные из веб-страниц с помощью выражений XPath. Его гибкость и возможность нацеливания на конкретные элементы делают его эффективным инструментом для извлечения данных с сайта, независимо от его структуры и формата.

Скраппинг API

API-скрепинг - это метод, позволяющий извлекать данные из API, представляющих собой интерфейсы прикладного программирования API обеспечивают связь и обмен данными между различными программными приложениями. Скраппинг API позволяет собирать данные, предоставляемые API, и использовать их в различных целях.

Скраппинг API заключается в выполнении HTTP-запроса к определенному URL-адресу и анализе полученных в ответ данных. Эти данные могут быть представлены в различных форматах, таких как JSON или XML, и могут содержать структурированную информацию, которую можно извлекать и редактировать. Некоторые API требуют аутентификации, поэтому в запросе может потребоваться ключ или маркер API.

Скраппинг API полезен во многих сценариях. Например, можно сканировать API социальных сетей для сбора данных о пользователях и сообщениях или сканировать API электронной коммерции для извлечения информации о товарах. Кроме того, с помощью API-скреппинга можно собирать данные для исследовательских и аналитических целей.

При работе с API важно прочитать и понять документацию по API, чтобы определить доступные конечные точки, параметры запроса и форматы ответа. Также важно соблюдать условия использования и ограничения на применение API-провайдера, чтобы избежать юридических или этических проблем. Кроме того, для обеспечения бесперебойной работы рекомендуется обрабатывать ошибки и исключения в используемом коде скраппинга.

Управление организационными проблемами скраппинга

Веб-скрепинг является мощным инструментом для извлечения данных с веб-сайтов, однако он также может создавать ряд проблем. Эти проблемы варьируются от технических до юридических и этических. Однако при тщательном планировании и рассмотрении эти проблемы могут быть эффективно решены.

Одной из распространенных проблем при веб-скреппинге является работа с динамическими сайтами, использующими JavaScript для загрузки содержимого, поскольку веб-скреперы обычно работают с запросом и разбором HTML-содержимого, которое в значительной степени опирается на JavaScript. Поэтому им бывает сложно извлечь данные с сайта. Для преодоления этой проблемы разработчики могут использовать такие инструменты, как безголовые браузеры и фреймворки для веб-скрепинга, которые могут обрабатывать JavaScript и предоставлять необходимые данные.

Еще одной проблемой при веб-скреппинге является избежание обнаружения и блокировки со стороны веб-сайтов. Многие веб-сайты принимают меры по обнаружению и блокированию веб-скреперов для защиты своего контента и ресурсов сервера. Для решения этой проблемы важно учитывать частоту использования скреперов, использовать анонимных посредников или смену IP-адресов для сокрытия личности скреперов и имитировать человеческие модели просмотра сайтов, чтобы не вызывать подозрений.

Юридические и этические аспекты также являются важными соображениями при проведении скраппинга в организациях. Некоторые сайты могут прямо запрещать скраппинг в своих условиях обслуживания или заявлять о праве собственности на данные, размещенные на их сайтах. Для решения этой проблемы рекомендуется ознакомиться с условиями обслуживания сайта, при необходимости получить разрешение и обеспечить ответственное использование полученных данных в соответствии с действующими законами и нормами.

Таким образом, решение проблем, связанных с веб-скреппингом, включает в себя преодоление технических ограничений, предотвращение обнаружения и блокирования, а также соблюдение правовых и этических норм. При эффективном решении этих задач веб-скрепинг может стать ценным инструментом для извлечения данных с веб-сайтов и получения информации для различных целей.

Обработка динамического контента

При соскабливании веб-сайтов в Интернете важно понимать, как обрабатывается динамическое содержимое. Под динамическим содержимым понимаются элементы веб-страницы, которые создаются или изменяются с помощью JavaScript или вызовов Ajax. Этот тип содержимого может быть трудно соскоблить, поскольку он может отсутствовать в исходном HTML-ответе.

Для сбора динамического содержимого может потребоваться использование безголовых браузеров или инструментов, способных выполнять JavaScript. Эти инструменты могут загрузить веб-страницу, дождаться отображения динамического содержимого и затем извлечь данные. Например, безголовые браузеры, такие как Puppeteer for JavaScript или Selenium for Python, могут использоваться для соскабливания веб-страниц с динамическим содержимым.

Другой подход к работе с динамическим содержимым заключается в анализе трафика веб-страниц. Отслеживая сетевые запросы и ответы, можно выявить запросы, извлекающие динамические данные. Затем эти запросы можно отправить вручную, а ответы в формате JSON или XML разобрать для извлечения необходимой информации.

Отметим также, что динамическое содержимое может загружаться не через JavaScript, а через API. В этом случае запрос может быть отправлен непосредственно на конечную точку API, а ответ может быть разобран для извлечения необходимых данных. Для этого могут быть полезны такие инструменты, как Postman или библиотеки запросов Python.

Таким образом, для обработки динамического содержимого при веб-скреппинге необходимо использовать безголовый браузер, анализировать сетевой трафик или напрямую обращаться к конечной точке API. Понимание того, как генерируется и извлекается динамическое содержимое, поможет вам эффективно обрабатывать веб-сайты, на которых для обновления содержимого используются вызовы JavaScript или Ajax.

Избежание блокировки IP-адресов

При сканировании веб-сайтов важно помнить о блокировке IP-адресов. На многих веб-сайтах предусмотрены меры безопасности, предотвращающие скраппинг; некоторые стратегии, позволяющие избежать блокировки IP-адресов, включают следующее

- Использование альтернативных прокси-серверов: переключение IP-адресов с помощью группы прокси-серверов. Это не позволит сайтам отслеживать действия по скраппингу на основе одного IP-адреса.

- Применять задержки: вставлять случайные паузы между запросами на скрепинг. Добавление паузы, имитирующей поведение человека, может остаться незамеченным и избежать срабатывания механизма блокировки IP-адресов.

- Use user agent: Укажите в запросе на скраппинг строку user agent, чтобы создать впечатление, что вы заходите на сайт с помощью обычного браузера. Чтобы избежать обнаружения, важно постоянно обновлять user agent и выдавать себя за другой браузер.

- Снятие соскоба в часы пик: снятие соскоба в часы пик может снизить вероятность активации блокировки IP-адресов. Веб-сайты с меньшей вероятностью будут внимательно следить за активностью в не самые загруженные часы.

- Применяйте управление сеансами: сохраняйте сеансы и повторно используйте один и тот же IP-адрес для нескольких запросов в рамках этого сеанса. Это позволяет создать более естественные схемы просмотра веб-страниц и предотвратить блокировку IP-адресов.

Важно отметить, что хотя эти стратегии позволяют свести к минимуму вероятность IP-исключения, они не могут гарантировать полной защиты. Веб-сайты, на которых применяются усовершенствованные превентивные меры, могут быть в состоянии обнаружить и исключить абразивную устойчивость. Всегда следует соблюдать условия использования сайта и помнить о влиянии снижения активности на сервер сайта.

Целостность и очистка данных

Важно обеспечить целостность экспортируемых данных на сервере сайта. Под целостностью данных понимается точность, последовательность и надежность информации. Часто на веб-сайтах могут встречаться ошибки или несоответствия в данных, что может повлиять на качество и достоверность изнашиваемых данных.

Для обеспечения целостности данных необходимо их очищать. Очистка данных предполагает выявление и исправление ошибок или несоответствий в собранных данных. Это может включать удаление двойных записей, исправление ошибок форматирования и стандартизацию данных для обеспечения согласованности.

Распространенная проблема, возникающая при проведении организационного скрейпинга, связана с отсутствием данных. Некоторые сайты могут содержать неполную или неполноценную информацию, что может повлиять на качество восстановленных данных. В таких случаях важно соответствующим образом решить проблему недостающих данных. Это может включать использование ценовой замены или реализацию документированной спекуляции для заполнения недостающей информации.

Еще одним аспектом очистки данных является работа с экстремальными ценами. Экстремальные цены - это точки данных, которые значительно отклоняются от нормального диапазона цен. Такие экстремальные значения могут быть вызваны ошибками или несоответствиями данных на сайте Origin. Важно правильно определить и обработать экстремальные значения, чтобы не исказить анализ или результаты, полученные на основе удаленных данных.

Очистка данных может также включать стандартизацию форматов и единиц измерения данных. Сайты могут использовать различные форматы и единицы измерения для одного и того же типа данных, что может привести к несоответствиям. Стандартизация данных облегчает их анализ и сравнение. Это может включать в себя преобразование единиц измерения, нормализацию значений и применение правил проверки данных.

В некоторых случаях может потребоваться использование современных методов очистки данных, таких как дедупликация и вычисление данных. Дедупликация данных предполагает выявление и удаление дублирующихся записей из отбракованных данных, а вычисление данных - оценку или заполнение недостающих данных на основе имеющейся информации.

Таким образом, целостность и очистка данных являются важными этапами работы по соскабливанию веб-данных. Обеспечение точности и надежности данных позволяет проводить полноценный анализ и принимать обоснованные решения на основе полученной информации.

Лучшие практики организационного скраппинга

Когда речь идет о скраппинге, существует ряд лучших практик, которые могут помочь обеспечить успешное и эффективное извлечение данных с веб-сайтов.

1. Соблюдайте условия использования сайта: прежде чем приступить к работе с сайтом, необходимо ознакомиться с условиями использования сайта или файлом robots.txt. Некоторые сайты могут прямо запрещать автоматический сбор данных, а другие могут иметь ограничения на частоту или объем скраппинга. 2.

2. Используйте подходящие инструменты для сбора данных: существует целый ряд инструментов для сбора данных с сайтов, таких как Beautiful Soup и Selenium. Важно выбрать подходящий инструмент в зависимости от сложности сайта и данных, которые необходимо извлечь. 3.

3. Соблюдайте этикет при работе с сайтами: при работе с сайтами важно проявлять уважение и не создавать лишней нагрузки на сервер сайта. Это включает в себя минимизацию количества запросов, использование задержек между запросами и отказ от одновременной загрузки нескольких страниц. 4.

4. Работа с динамическим содержимым: многие веб-сайты в настоящее время используют JavaScript для создания динамического содержимого, что может создать проблемы при скраппинге. Важно убедиться, что используемые скреперы могут работать с JavaScript-рендерингом или извлекать данные с сайтов с динамическим содержимым с помощью таких технологий, как headless-браузеры.

5. обработка ошибок и исключений: при веб-скреппинге могут возникать ошибки, например, таймаут соединения или отсутствие элементов на странице. Важно достойно справляться с этими ошибками, применяя соответствующие механизмы обработки ошибок и повторных попыток.

6. регулярно отслеживайте и обновляйте скреперы: веб-сайты постоянно развиваются, и их структура может меняться с течением времени. Важно регулярно отслеживать и обновлять скрипты, чтобы они продолжали корректно работать даже при изменении макета или структуры сайта.

7. Помните о конфиденциальности и законности данных: при сканировании веб-сайтов важно помнить о юридических ограничениях и проблемах конфиденциальности. Рекомендуется сканировать только общедоступные данные и не соскабливать конфиденциальную или личную информацию без соответствующего согласия.

Соблюдение этих правил позволит эффективно и ответственно проводить скраппинг и извлекать из веб-сайтов ценные данные для различных целей.

Соблюдайте условия использования веб-сайта

При использовании веб-сайтов в режиме онлайн важно соблюдать и выполнять условия использования веб-сайта (TOS). Эти рекомендации и правила устанавливаются владельцем сайта и должны соблюдаться для обеспечения этичного и законного извлечения данных.

Проверьте файл robots. txt сайта.

Прежде чем приступать к сканированию сайта, необходимо проверить, есть ли на нем файл robots.txt. Этот файл содержит инструкции для веб-краулеров и определяет, какие части сайта разрешены для доступа и соскабливания; следуйте правилам, перечисленным в файле robots.txt, чтобы избежать юридических проблем и поддерживать хорошую практику соскабливания.

Правила "за" и "против".

- Не стоит:

- Прочитать и понять условия использования сайта.

- Ответственно подходите к скраппингу и не перегружайте сервер большим количеством запросов.

- Соблюдайте установленные ограничения скорости или рекомендации по скрапбукингу.

- При необходимости приводить ссылки на источник данных.

- Используйте соответствующий уровень анонимности и соблюдайте политику конфиденциальности сайта.

- Не следует:.

- Сканировать личную или конфиденциальную информацию без прямого разрешения.

- Сканировать содержимое, нарушающее законы об авторском праве или защищенное авторским правом.

- Отключать или обходить меры безопасности, применяемые сайтом.

- Пытаться получить несанкционированный доступ к закрытым областям сайта.

- Использовать соскобленные данные в злонамеренных целях или для незаконной деятельности.

Правовые последствия.

Несоблюдение условий использования веб-сайта и участие в несанкционированной деятельности по скрапбукингу может привести к юридической ответственности: веб-сайты имеют право защищать свое содержимое и данные, и нарушение условий их использования может привести к судебным искам, включая уведомления о приостановке работы и судебные разбирательства. Важно подходить к работе с сайтами ответственно и в пределах, установленных соответствующими условиями использования.

Использование агентов пользователя и заголовков

Агент пользователя - это текстовая строка, которая передается в составе HTTP-заголовков при запросе веб-страницы. Она идентифицирует запрашивающий браузер или программное обеспечение, а также может использоваться для выдачи себя за другой браузер или устройство.

При соскабливании веб-страниц обычно определяются пользовательские агенты, имитирующие реальные браузеры. Настройка специального агента пользователя позволяет избежать обнаружения и блокирования серверами сайта. Это также позволяет сканировать сайт так, как будто вы используете другой браузер или устройство.

Заголовки - важная часть процесса HTTP-запроса и ответа. Они содержат дополнительную информацию и инструкции о веб-сервере. Манипулируя заголовками, можно изменить поведение веб-сервера и улучшить процесс сканирования.

Например, можно добавлять заголовки для определения языка и кодировки запросов, установки cookies и управления кэшированием. Также с помощью заголовков можно передавать аутентификационную информацию, например ключи или маркеры API, при доступе к защищенным ресурсам.

Использование агентов пользователя и заголовков при веб-скреппинге является мощным методом контроля и регулирования запросов на веб-скреппинг. Это позволяет избежать обнаружения, обойти ограничения и эффективно и качественно собрать необходимые данные. Однако при этом важно соблюдать условия использования сайта и не злоупотреблять процессом скраппинга.

Применять ограничения скорости.

Ограничение скорости - это важный метод контроля количества запросов, которые могут быть сделаны к сайту в течение определенного времени. Это позволяет предотвратить злоупотребления, защитить ресурсы сервера и обеспечить справедливую политику использования для всех пользователей.

Для реализации ограничения скорости можно использовать несколько стратегий, в том числе

- Установка общего лимита: можно установить максимальное количество запросов, которое пользователь или IP-адрес может выполнить в течение определенного периода времени. По достижении лимита дальнейшие запросы будут отклонены или отложены.

- При использовании системы, основанной на ваучерах, каждый ваучер представляет собой определенное количество заявок. После того как все ваучеры использованы, пользователь или IP-адрес должен подождать определенное время, чтобы получить новые ваучеры.

- Применение скользящих окон: данная технология допускает определенное количество заявок в течение фиксированного времени, например, одной или пяти минут. Если в течение этого периода количество запросов превышает установленный лимит, дальнейшие запросы либо отклоняются, либо откладываются.

При введении ограничений на количество запросов важно учитывать такие факторы, как удобство работы пользователей, производительность системы и специфические потребности сайта. Может потребоваться корректировка лимитов в зависимости от типа запроса, ресурсов, необходимых для его обработки, и требуемого уровня защиты.

Кроме того, можно выдавать соответствующие сообщения об ошибках или заголовки ответов, чтобы информировать пользователей об ограничениях скорости и о том, когда они могут делать новые запросы. Это поможет управлять ожиданиями и обеспечит лучший опыт для пользователей.

В целом, внедрение ограничения скорости является важным шагом в области веб-скреппинга, обеспечивающим ответственное и уважительное использование ресурсов сайта, а также поддержание целостности и доступности сайта для всех пользователей.

Комментарии